Les agents conversationnels en classe

/ Actualités, Eduquer à l'IA, IA pour les apprentissages, Intelligence artificielle, Se former à l'IA

Depuis l’essor spectaculaire des modèles de langage de grande taille (LLM), les agents conversationnels se sont multipliés dans nos usages quotidiens, y compris dans les sphères éducatives. Des plateformes généralistes comme ChatGPT ou Gemini, ou spécialisés comme Mizou ou encore ChatMD sont désormais connues d’un nombre croissant d’enseignants et d’élèves, et suscitent des usages formels comme informels, encadrés comme spontanés.

Cette rapide diffusion interroge le monde éducatif : quels sont les apports potentiels de ces agents dans les apprentissages ? Quelles limites ou risques comportent-ils ? Et surtout, sous quelles conditions peuvent-ils être intégrés de manière pertinente, éthique et pédagogique dans les pratiques d’enseignement et d’apprentissage ?

Cet article propose de faire le point sur ce que sont les agents conversationnels, ce qu’ils permettent aujourd’hui dans l’éducation, et les conditions d’un usage raisonné, à la fois lucide sur leurs limites et ouvert à leurs possibles.

Une vieille idée renouvelée par les LLM

L’idée d’interagir avec une machine par le langage n’est pas nouvelle. Dès 1966, Joseph Weizenbaum mettait au point ELIZA, un programme capable de simuler les réponses d’un psychothérapeute en reformulant les propos de l’utilisateur. Cette première illusion de dialogue marquait le début d’une longue histoire : celle des agents artificiels capables de converser, ou du moins de donner cette impression.

Dans le champ éducatif, ces agents ont rapidement été mobilisés dans le cadre de projets de tutorat intelligent. À partir des années 2000, des systèmes comme AutoTutor ou ALEKS tentaient de personnaliser l’apprentissage grâce à des modèles experts, pédagogiques et diagnostiques, offrant un encadrement automatisé des élèves. Ces dispositifs relevaient de l’intelligence artificielle symbolique, reposant sur des règles explicites et des arbres de décision.

Ce qui change aujourd’hui, c’est l’arrivée de modèles massivement entraînés sur des corpus textuels géants, capables de générer des réponses en langage naturel d’une étonnante fluidité. Ces modèles de langage de grande taille (LLM), comme GPT-3.5 ou Llama…, ont été conçus pour prédire le mot suivant dans une séquence de texte, mais produisent, par ce mécanisme, des dialogues crédibles, riches, et souvent pertinents.

Cette fluidité et cette accessibilité (via des interfaces conversationnelles comme ChatGPT) constituent un tournant. Là où les anciens systèmes exigeaient des compétences techniques et des infrastructures spécialisées, les LLM démocratisent l’usage des agents conversationnels. Ils ne rendent pas l’agent conversationnel possible — ils le rendent banal.

Dans ce nouveau contexte, une confusion est fréquente : celle qui consiste à assimiler tout chatbot à un tuteur intelligent. Or, si la conversation est devenue techniquement plus aisée, cela ne signifie pas que les agents issus des LLM sont pour autant des dispositifs pédagogiques pensés. Un agent conversationnel n’est pas nécessairement un outil d’enseignement : tout dépend de son design, de ses objectifs, de son intégration dans un cadre éducatif.

Comment les LLM sont devenus des agents conversationnels

Un modèle de langage (LLM) tel que GPT n’est pas, en soi, un agent conversationnel. Il s’agit d’un algorithme entraîné à prédire le mot suivant dans une séquence de texte, à partir d’un immense corpus issu du web, de livres, de forums ou d’articles scientifiques. Ce principe statistique fondamental produit des résultats étonnants, mais ne suffit pas à générer une interaction fluide, contextualisée et coopérative.

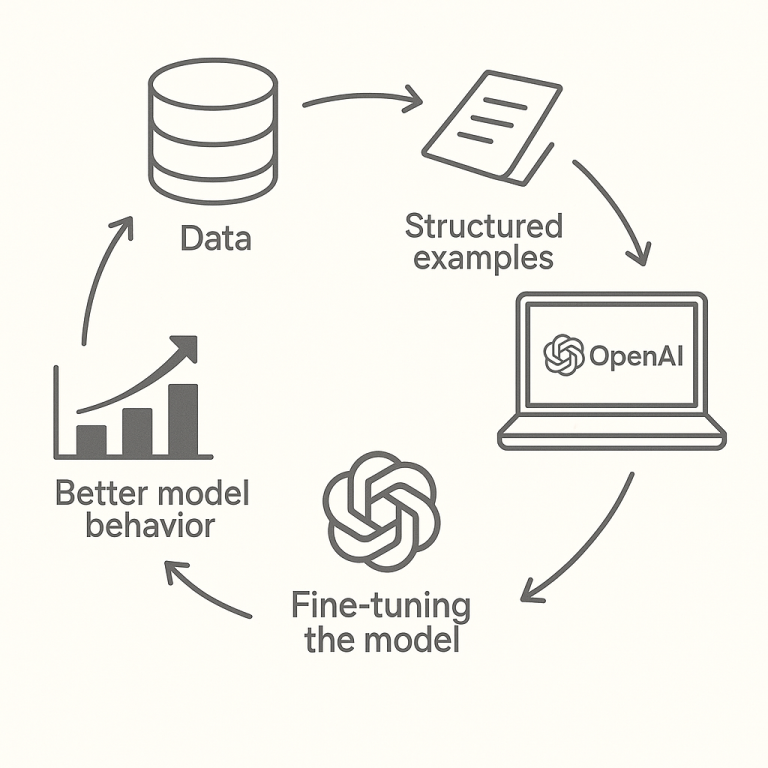

Pour transformer un LLM en chatbot utilisable par un humain, deux étapes majeures sont nécessaires.

L’ajustement par instruction : fine-tuning

La première étape consiste à entraîner le modèle à répondre à des consignes formulées en langage naturel. On lui présente des paires du type « instruction ➝ réponse », avec des formulations variées (« Résume ce texte », « Donne un exemple », « Quelle est la différence entre… »).

Cette phase, appelée instruction fine-tuning, permet au modèle de comprendre qu’on attend de lui un certain rôle conversationnel (enseignant, assistant, conseiller…) et qu’il doit y répondre de manière claire, directe et orientée vers l’utilisateur.

L’ajustement par renforcement : RLHF

Le second ajustement, crucial, est le Renforcement par apprentissage avec retour humain (Reinforcement Learning from Human Feedback ou RLHF). Des annotateurs humains évaluent des centaines de réponses possibles générées par le modèle et indiquent celles qui sont les plus satisfaisantes (pertinentes, non toxiques, utiles, grammaticalement correctes, etc.). À partir de ces préférences humaines, le modèle apprend à prioriser certains types de réponses.

C’est grâce à cette étape que les agents comme ChatGPT ou Mizou savent :

- éviter certains propos discriminants ou problématiques,

- maintenir un ton adapté, souvent bienveillant,

- produire des réponses structurées, avec des marqueurs conversationnels (bonjour, merci, “voici ce que je peux dire…”).

Un comportement simulé, pas une compréhension réelle

Le résultat de ce double ajustement donne l’impression qu’on a affaire à un véritable agent conversationnel doué de compréhension. Mais il ne s’agit toujours que de prédiction contextuelle guidée par des statistiques. Le modèle ne comprend pas ce qu’il dit : il simule une réponse plausible à partir de ce qu’il a déjà vu, sans intention ni vérification factuelle.

Ce fonctionnement génère un effet connu : celui de l’illusion de pertinence. Parce que la réponse semble structurée, rassurante et fluide, elle donne le sentiment qu’elle est fiable — même lorsqu’elle est erronée ou inventée.

Dans un cadre éducatif, cette ambiguïté est décisive. Elle fait des agents conversationnels des outils puissants, mais fondamentalement ambivalents : porteurs d’une interaction simulée qui peut enrichir l’apprentissage… ou le désorienter.

Des rôles pédagogiques pluriels

La force des agents conversationnels ne réside pas seulement dans leur capacité à formuler des réponses, mais dans la pluralité des rôles qu’ils peuvent endosser dans un contexte éducatif. En fonction du scénario d’usage et des intentions de l’enseignant, un agent conversationnel peut jouer différents rôles dans la relation pédagogique.

Une revue de la littérature scientifique conduite par Kuhail et al. (2022) identifient quatre grandes fonctions typiques des agents conversationnels éducatifs.

Le rôle d’enseignant

L’agent fournit du contenu, guide l’apprenant dans ses réponses, reformule, corrige. Il pose des questions, propose des exercices ou synthétise des notions. Il s’inscrit ici dans une logique de transmission structurée du savoir, souvent en complément ou en relais de l’enseignant humain.

Le rôle de pair ou de compagnon

Dans ce cas, l’agent est conçu pour simuler un interlocuteur de niveau comparable à celui de l’élève. Il discute, échange, reformule les idées, mais sans position de supériorité. Cette fonction favorise une approche plus horizontale, encourageant la verbalisation, la coopération, voire l’émulation.

Le rôle d’agent “enseignable”

C’est une posture inversée : l’élève enseigne à l’agent ce qu’il sait. Ce renversement de perspective s’inscrit dans la logique de l’apprentissage par l’explication (teaching to learn) : expliquer à autrui (même simulé) permet de consolider ses propres acquis.

Le rôle motivationnel ou socio-affectif

L’agent conversationnel peut aussi remplir une fonction de soutien émotionnel : il encourage, félicite, rassure. En offrant un feedback immédiat et une écoute simulée sans jugement, il peut renforcer l’engagement et la persévérance des apprenants.

Une palette fonctionnelle, mais pas toujours maîtrisée

Ces fonctions peuvent se combiner ou alterner au fil de l’interaction, selon la conception du scénario pédagogique. Mais elles ne sont pas toujours clairement identifiées ni exploitées consciemment par les enseignants ou les concepteurs. De plus, rien ne garantit que l’agent remplisse correctement le rôle qui lui est attribué : un chatbot généraliste peut se montrer trop directif, ou au contraire trop vague ; un agent supposé soutenir peut décourager s’il donne des réponses erronées.Lorem ipsum dolor sit amet, consectetur adipiscing elit. Ut elit tellus, luctus nec ullamcorper mattis, pulvinar dapibus leo.

Il est donc essentiel de penser l’intention pédagogique et de concevoir l’interaction en fonction d’un rôle clairement défini, afin que l’agent conversationnel ne soit pas simplement un outil qui répond, mais un acteur intégré d’un dispositif d’apprentissage.

Bénéfices et limites d’un point de vue éducatif

L’engouement pour les agents conversationnels dans l’éducation se nourrit d’une promesse forte : celle d’un apprentissage plus personnalisé, interactif et engageant. De nombreux bénéfices sont avancés, mais ils s’accompagnent de limites structurelles, méthodologiques et éthiques qu’il convient de considérer avec lucidité.

Les bénéfices pédagogiques attendus

Les agents conversationnels présentent plusieurs atouts pédagogiques notables. Leur capacité à s’adapter aux réponses des élèves permet de personnaliser les échanges en fonction du niveau et du rythme de chacun, facilitant ainsi la différenciation. Ils offrent également un feedback immédiat, atout pour favoriser l’auto-correction, renforcer la compréhension et consolider les apprentissages. Le dialogue simulé qu’ils proposent crée un cadre d’interaction sans jugement, stimulant l’engagement, en particulier chez les élèves en difficulté avec les formats scolaires traditionnels. Enfin, leur accessibilité permanente en fait des alliés utiles pour accompagner les élèves au-delà de la classe, dans une logique d’autoformation.

Des limites pédagogiques et cognitives

Malgré leurs atouts, les agents conversationnels présentent aussi des limites importantes. Leurs réponses, souvent bien formulées, peuvent donner une illusion de pertinence sans reposer sur une compréhension réelle, exposant ainsi les élèves à des savoirs superficiels. Par ailleurs, ces outils ne régulent pas finement les apprentissages : ils peinent à identifier les blocages conceptuels ou à accompagner une structuration progressive de la pensée. Enfin, en apportant des réponses immédiates, ils peuvent induire une forme de dépendance cognitive, réduisant l’effort d’analyse, de mémorisation ou de formulation personnelle des élèves.

Enfin, il manque encore des recherches approfondies et à large échelle pour démontrer de manière rigoureuse les bénéfices réels de ces outils.

Des enjeux éthiques et sociétaux

Trois formes d’usage en contexte éducatif

Si les agents conversationnels sont désormais accessibles à tous, leur mode d’intégration dans les pratiques scolaires varie fortement. On peut distinguer trois formes d’usage, qui coexistent et parfois se croisent : l’usage spontané des élèves, l’usage encadré par des enseignants dans des dispositifs pédagogiques structurés, et l’usage hybride où l’enseignant conçoit un cadre d’interaction ouvert, enrichi par des bases documentaires ou des modèles plus puissants.

Usages spontanés, autonomes ou “sauvages”

De nombreux élèves ont pris l’initiative d’utiliser des agents conversationnels comme ChatGPT hors du cadre scolaire, pour s’aider à faire leurs devoirs, réviser, reformuler, ou même simuler un dialogue. Cette appropriation rapide montre une certaine autonomie numérique : les élèves explorent, testent, interrogent… parfois avec créativité.

Mais ces usages souffrent d’un manque de cadre critique. L’élève prend souvent la réponse générée pour vraie, sans interroger sa source, son niveau de complexité ou son adéquation au travail demandé. Le risque est celui d’un apprentissage assisté mais mal compris, où l’agent conversationnel devient un fournisseur de réponse plus qu’un partenaire de pensée.

Ces pratiques montrent la nécessité d’intégrer la formation aux agents conversationnels dans le curriculum, pour que les élèves puissent exploiter ces outils sans en devenir dépendants ou dupes.

Dispositifs encadrés : ChatMD

Certains enseignants ont conçu des agents conversationnels scénarisés, avec un objectif pédagogique précis. Un exemple français mérite une attention particulière.

ChatMD est outil libre permettant de créer des dialogues prédéfinis à partir de fichiers en Markdown. Il ne repose pas sur un LLM, mais sur une structure de choix guidés. Cela permet de maîtriser totalement le contenu et le déroulé du dialogue, sans imprévu.

Dans ces cas, l’agent conversationnel devient un prolongement de la démarche pédagogique, conçu pour accompagner l’élève dans une tâche ciblée : révision, orientation, exploration ludique, entraînement, etc.

Chatbots enrichis : LLM + RAG

Une voie intermédiaire se développe : celle des agents conversationnels enrichis par un moteur LLM et, éventuellement, connectés à une base documentaire (RAG : Retrieval-Augmented Generation).

C’est notamment le cas de l’application Mizou ou de certaines évolutions de ChatMD.

L’idée est de combiner :

- une structure conversationnelle scénarisée (étapes pédagogiques définies),

- une capacité d’ouverture vers des documents validés (avec le RAG), extraits en temps réel,

- une réponse générée qui s’appuie à la fois sur la requête de l’élève et sur des sources fiables.

Cette forme hybride pourrait représenter un compromis fécond entre :

- la liberté d’exploration offerte par les LLM,

- et la maîtrise pédagogique exigée dans le cadre scolaire.

C’est pourquoi des projets sont en cours de développement, comme ANSU (Agent Numérique de Suivi), initié dans l’académie d’Aix-Marseille, qui vise à accompagner les élèves dans leur progression par un dialogue personnalisé fondé sur leurs acquis et leurs difficultés identifiés. Ce type de dispositif illustre le potentiel d’un agent conversationnel centré sur les besoins éducatifs réels, adossé à des données contextualisées.

Mais ce type d’outil demande des compétences à la fois techniques et pédagogiques de la part des concepteurs : scénarisation, choix des sources, encadrement des réponses, compréhension des limites.

Ces trois formes d’usage posent une même question fondamentale : comment accompagner l’interaction pour qu’elle devienne un levier d’apprentissage, et non un simple raccourci vers une réponse ?

Tableau de comparaison de deux exemples d’outils permettant aux enseignants de créer des agents conversationnels pédagogiques.

- Mizou

- ChatMD

| Mizou | ChatMD | |

3999 /year | $ /year | |

| Type d’agent | Chatbot génératif | Agent guidé par scripts (Markdown), sans génération automatique |

| Objectif principal | Créer des dialogues interactifs pour la classe | Scénariser des parcours de dialogue à étapes fixes |

| Contrôle pédagogique | Intermédiaire : l’enseignant fixe des objectifs et des règles | Très élevé, contrôle total du contenu et du parcours |

| Niveau technique requis | Faible à moyen (interface visuelle, sans code nécessaire) | Moyen à élevé (écriture en Markdown, logique conditionnelle) |

| Réactivité du chatbot | Générative | Réponses entièrement définies à l’avance ou Possibilité de connecter à une API d’un LLM |

| Partage et intégration | Facile, via interface web | Intégration facile en ligne ou via Moodle (Widget ou iframe) |

| Exemples pédagogiques | Oui, via bibliothèque de chatbots sur le site ou via Édubase pour des retours plus détaillés | Oui, via partages de scénarios sur la documentation et le salon Tchap |

| Type de tâches possibles | Révision et mémorisation active, Débats et argumentation,Soutien à la production écrite et orale, Exploration de concepts complexes, Évaluations formatives, Pratique des langues étrangères, Jeux éducatifs et aventures interactives | Tutoriel pour un logiciel ou un outil, FAQ, Guide d’un établissement, Outil de formation à destination de la communauté enseignante, Outil de révision de connaissances ou d’aide méthodologique, Guide de découverte ou d’exploration d’un sujet, Escape Game, aventure, enquête |

| Prix | Version gratuite (limitée) ou avec abonnement | Libre et gratuit |

| Buy Now | Buy Now |

Pour un usage raisonné : balises et conditions

Si les agents conversationnels suscitent autant d’intérêt que de réserves, c’est parce qu’ils cristallisent une tension profonde entre la promesse d’un accompagnement intelligent et le risque d’une délégation aveugle. Pour dépasser cette tension, il ne suffit pas d’ouvrir ou de fermer la porte à ces outils. Il faut en penser les conditions d’usage, à la fois pédagogiques, éthiques et formatives.

Un alignement pédagogique explicite

Tout usage d’un agent conversationnel doit être relié à un objectif d’apprentissage clair. L’outil ne crée pas en lui-même du sens pédagogique : c’est son intégration dans une séquence, une tâche ou une progression qui lui donne sa valeur éducative.

- Quelle compétence vise-t-on ?

- Quelle place donne-t-on à l’élève dans l’échange ?

- Comment s’assure-t-on que l’agent accompagne sans se substituer ?

Un usage raisonné commence par ce questionnement.

Un cadre éthique exigeant

L’usage des agents conversationnels en contexte éducatif doit s’inscrire dans un cadre éthique rigoureux. D’abord, leur empreinte écologique, liée à une forte consommation de ressources, invite à des usages sobres et justifiés. Ensuite, il est essentiel de préserver l’agentivité des élèves : l’outil ne doit pas se substituer à leur réflexion, mais au contraire encourager l’expérimentation et la reformulation. La place de l’enseignant reste centrale, car aucun agent ne peut évaluer, ressentir ou créer un lien de confiance. Enfin, une exigence de transparence s’impose : les utilisateurs doivent comprendre le fonctionnement des systèmes et leurs limites. Les solutions ouvertes, modulables et documentées représentent à cet égard des alternatives précieuses.

L’expérimentation comme levier de formation

Pour les enseignants, l’intégration des agents conversationnels ne peut reposer uniquement sur des discours descendants ou des injonctions techniques. Il faut leur offrir des espaces d’expérimentation critique, où ils peuvent tester, observer, ajuster les outils à leur pratique réelle.

Ces temps de formation devraient :

- confronter différents types d’agents (guidés, génératifs, hybrides),

- analyser les écarts entre ce que l’on attend et ce que l’outil fait,

- faire émerger des critères pédagogiques de choix et de régulation.

La formation des élèves : autonomie critique et littératie numérique

Former les élèves à l’usage des agents conversationnels ne relève pas d’un simple accompagnement technique : c’est un enjeu fondamental de littératie numérique et de citoyenneté critique. Il s’agit de leur permettre de comprendre le fonctionnement de ces outils, fondés sur la prédiction statistique, et de prendre du recul sur les réponses générées, qui ne sont ni neutres ni toujours fiables. Cela implique d’apprendre à vérifier les sources, à identifier les biais, à croiser les informations et à réfléchir à l’impact de ces outils sur leurs propres manières d’apprendre, de s’exprimer, de raisonner.

Cet apprentissage est d’autant plus nécessaire que les agents conversationnels débordent largement le cadre scolaire. Les jeunes les utilisent déjà dans leur vie quotidienne, parfois sous des formes plus immersives et affectives : IA “amies”, assistants vocaux personnalisés, ou chatbots intégrés à des applications sociales. Certains agents simulent l’écoute, l’affection, voire la relation, et peuvent influencer les émotions ou les représentations de soi. Dans ce contexte, l’enjeu éducatif est de former des usagers lucides et critiques, capables de faire la part entre interaction simulée et relation réelle, entre commodité technologique et autonomie intellectuelle.

Autrement dit, il ne s’agit pas seulement d’apprendre à utiliser ces outils, mais d’apprendre à se positionner face à eux.

Conclusion

Les agents conversationnels ne sont ni une mode passagère ni une solution miracle. Ils constituent une évolution technologique, dont l’impact sur l’éducation est encore largement à déterminer. Il dépendra moins de leurs performances techniques que de la manière dont ils seront pensés, encadrés et accompagnés.

Leur intégration raisonnée exige une double vigilance :

- d’un côté, une lucidité critique sur leurs limites, leurs effets de surface, leurs biais et leur coût écologique ;

- de l’autre, une curiosité pédagogique pour explorer leur potentiel d’individualisation, d’entraînement et de médiation.

Ils nous rappellent, en creux, ce que l’enseignement repose sur : la lenteur, la reformulation, le conflit cognitif, la relation humaine, la construction du sens. Autant d’éléments que la conversation simulée ne peut pas produire seule, mais qu’elle peut — si elle est bien conçue — favoriser, soutenir, prolonger.

Le défi est donc clair : faire des agents conversationnels non des substituts, mais des outils au service d’une pédagogie plus réflexive, plus différenciée et plus humaine.